Künstliche Intelligenz kann alles: Sie malt Bilder, sie schreibt Texte, sie fälscht Videos und sie imitiert uns Menschen in allem, was uns ausmacht. Es stellt sich die Frage: Macht sie uns auch unsere Stimme streitig?

Denn anfangs Jahr konnten wir lesen, dass Apple Hörbücher von künstlichen Sprecherinnen vorlesen lassen will¹. Und Audio deepfakes sind auch schon ein Thema: Das sind Aufnahmen, in denen jemand Prominentes etwas sagt, das er in Wirklichkeit nicht gesagt hat.

Doch wie gut sind solche Imitationen? Ich habe die Probe aufs Exempel gemacht: Mit resemble.ai können wir unsere Stimme klonen und mit ihr hinterher Texte vorlesen lassen. Das scheint inzwischen mehr als bloss eine Experimentierwiese zu sein. Der Betreiber schreibt auf der Website, mehr als 200’000 KI-Stimmen würden pro Monat etwa zwei Millionen Minuten Audio einsprechen.

Die KI-Stimmen begegnen uns längst im Alltag

Falls das stimmt, ist das eindrücklich und würde bedeuten, dass uns diese Stimmen auch im Alltag begegnen. Als Einsatzbereiche werden Callcenter, smarte Assistenten, Werbung, Unterhaltung und die bereits erwähnten Hörbücher genannt. Für die reguläre Nutzung zahlen wir 0,006 Cent pro Sekunde, also 21,60 Dollar pro Stunde. Nicht günstig, aber völlig in Ordnung, angesichts der Tatsache, dass wir zu jeder Tages- und Nachtzeit eine Aufnahme erstellen können, einfach, indem wir einen Text in ein Feld eingeben und ihn durch die Sprachsynthese jagen.

Um meine eigene Stimme zu klonen, muss ich 25 Sätze einsprechen. Ein Beispiel nebst 24 anderen: Her maid was standing by the garden gate, looking for her.

Ich kann mir die Aufnahmen jeweils anhören und sie wiederholen, falls etwas nicht stimmt – ob es fatale Auswirkungen hat, wenn man nicht genau das liest, was man sollte, habe ich nicht ausprobiert. Es wäre aber interessant zu wissen.

Dann müssen wir uns in Geduld üben, während die Stimme erzeugt wird – das passiert nicht sofort. Es könne bis zu zwei Tagen dauern, heisst es. In meinem Fall war die Stimme aber nach gut einer Stunde fertig.

Wieso nicht gleich William Shakespeare als erstes Projekt?

Ist die Stimme parat, loggen wir uns unter app.resemble.ai ein und eröffnen ein Projekt.

Es erscheint ein Editor, in dem wir nun wie in einem Drehbuch den Text eintragen – das heisst, wir können nicht nur Monologe, sondern auch Dialoge mit mehreren Beteiligten erzeugen. Wir wählen für jede Passagen jeweils den Sprecher: Falls wir selbst mehrere Stimmen eingesprochen haben, können wir die auswählen; ansonsten stehen einige Standard-Stimmen zur Auswahl. Für meine Darbietung aus William Shakespeare Romeo und Julia – in der ich natürlich den Romeo gebe – wähle ich als Partnerin Beth. Die spricht leider amerikanisches Englisch; für britisches Englisch steht nur ein Mann zur Auswahl.

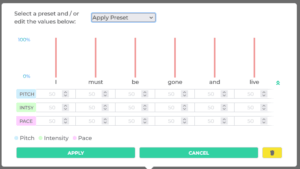

In diesem Editor beeinflussen wir den Vortrag durch diverse Optionen: Wir markieren, wo Pausen eingelegt werden sollen, welche Passagen zu betonen sind und es gibt sogar einen Editor, um die Emotionen zu modellieren. Das ist eindrücklich, was die Möglichkeiten angeht. Doch es liegt auf der Hand, dass wir hier nicht gleich vom Fleck weg die richtigen Optionen wählen: Damit hier etwas Vernünftiges herauskommt, braucht es einen erfahrenen … wie würde man diesen Beruf nennen? Einen Textsynthese-Regisseur?

Ethische und monetäre Dilemmas

Dieses Prozedere ist aufwändig: Ob man wirklich Zeit spart, als wenn man im Studio mit echten, erfahrenen Schauspielern verschiedene Varianten durchprobieren kann? Ich habe meine Zweifel.

Und noch eine interessante Frage, die sowohl mit Geld als auch mit Ethik zu tun hat: Wie müsste es abgegolten werden, wenn jemand seine Stimme hergibt? Als Schauspieler bzw. Sprecherin würde er oder sie sich hinterher selbst konkurrieren. Die KI-Stimme würde ihm oder ihr zumindest einen Teil von Aufträgen abjagen. Wie viel sollte das kosten? Fair wäre nur eine Summe, mit der ein solcher Voice Artist nie wieder arbeiten müsste. Aber so, wie wir den Kapitalismus kennengelernt haben, wird das nicht der Fall sein. Ich halte eine symbolische Entschädigung, die den eigentlichen Wert nicht ansatzweise reflektiert, für wahrscheinlicher – vor allem bei Leuten, die mit einer tollen Stimme gesegnet sind, die aber am Anfang ihrer Karriere stehen und die Tücken des Geschäfts noch nicht durchschauen. Und die keinen oder keinen guten Agenten haben.

Schliesslich fragt es sich, ob mit einer Datenbank, wie sie bei resemble.ai vorhanden ist, nicht auch Stimmen aus dem Nichts generieren lassen, die hervorragend klingen, sich aber nicht direkt auf eine einzige Person zurückführen lassen. Das allein spricht gegen eine grosszügige Entgeltung an Menschen, die ihre Stimme hergeben: Wenn die zu teuer sind, dann werden sie durch einen Klon ersetzt, der ähnlich klingt, aber nicht so ähnlich, dass bei einer Klage Erfolgsaussichten bestünden.

Erzeugen und herunterladen

Aber zurück zum Test: Wenn wir einigermassen sicher sind, vernünftige Einstellungen vorgenommen zu haben, dann können wir uns die Darbietung anhören und über den Knopf Create all als fertiges Audio herunterladen. Als Formatoption steht WAV in Profi-Qualität zur Verfügung – einziger Kritikpunkt: Die maximale Abtastrate ist 44,1 kHz, für meine eigenen Projekte würde ich 48 kHz vorziehen.

Das Resultate meines Shakespeare-Experiments ist durchwachsen. Julia, alias KI-Beth, rattert ihren Text etwas gar uninspiriert herunter – da ist KI-Matthias im Vergleich geradezu ein Schauspieltalent.

Und ja, das anzuhören, ist wirklich, wirklich seltsam. Mich packt das metaphysische Gruseln, das Mani Matter in seinem Stück «Bim Coiffeur» besungen hat. Wenn mir jemand die Aufnahme vorgespielt und behauptet hätte, die Aufnahme sei fünf Jahre alt und ich würde mich bloss nicht mehr daran erinnern, wie ich sie eingesprochen habe – dann hätte ich ihm das vermutlich geglaubt. Es klingt so, als ob ich das wäre. Und auch wieder nicht.

Im Vergleich zu der geklonten Stimme hatte ich mit den «magischen Avataren», die ich hier von mir habe erstellen lassen, viel weniger Mühe. Die Figuren, die dort herausgekommen sind, wirken wie Fastnacht; wie ein unverbindlicher Schabernack. Doch die Stimme – die ist persönlich und ein Teil der Identität. Wenn die einem von der Maschine streitig gemacht wird, dann ist das ein ganz anderes Kaliber.

Fussnoten

1) Ich fand das eine doofe Idee. Ich will Hörbücher hören, die von echten Menschen geschrieben wurden und auch der Vortrag soll von einem Mitglied meiner Spezies geleistet werden. Aber es gab einige Leute, die der Idee etwas abgewinnen konnten. Das Argument lautet im Kern, dass KIs Dinge vorlesen können, für die es keinen Markt gibt, der es rechtfertigen würde, einen Menschen zu engagieren. Dagegen ist kaum etwas einzuwenden, aber das spricht auch dagegen, mit dieser Idee bei den Hörbüchern anzusetzen. ↩

Beitragsbild: Adobe Firefly zum Prompt: «a female and a male robot, who stand around a microphone».