Vor zwei Monaten habe ich Bing Chat einem Test unterzogen. Bing Chat bzw. The New Bing ist die Erweiterung von Microsofts Suchmaschine, die mittels künstlicher Intelligenz Fragen direkt beantwortet. Damals war Bing noch in einem Versuchsstadium und das Resultat verheerend: Was sich bei Microsoft anbahnt, ist eine Katastrophe, war mein Fazit damals.

Seit letzter Woche ist Bing ohne Warteliste für alle Nutzerinnen und Nutzer verfügbar. Das ist eine gute Gelegenheit, den Versuch zu wiederholen: Ist Bing besser geworden? Oder wurden wenigstens die ärgsten Mängel beseitigt?

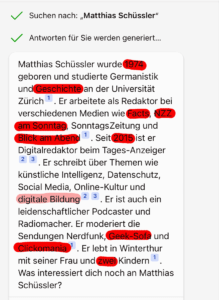

Mein Test seinerzeit war simpel: Ich habe Bing nach mir gefragt und geprüft, ob das, was er erzählt, den Tatsachen entspricht. Das war nicht der Fall: Bing hat mir sieben Sätze zurückgeliefert, in denen geschlagene neuneinhalb Fehler enthalten waren. Das ist ohne Zweifel unbrauchbar.

Von neun auf null Fehler

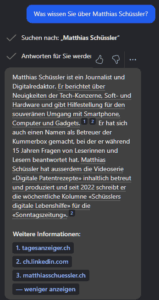

Nun habe ich am letzten Freitag den Versuch wiederholt und war überrascht. Das Resultat war markant besser. Nämlich fehlerfrei – allerdings auch mit deutlich weniger Informationsgehalt. Bing hat den Jahrgang weggelassen, ebenso meinen Werdegang und die Angaben zu meiner Familie und dem Wohnort.

In die Antwort sind zwei Quellen eingeflossen, nämlich meine Kurz-Biografie bei der Tamedia und mein Linkedin-Profil, das ich letzte Woche aktualisiert habe. Meine private Website ist zwar als Quelle aufgeführt, wurde aber nicht für die Zusammenfassung verwendet.

Daraus ergibt sich ein handfester Tipp: Leute, die keine Wikipedia-Seite ihr Eigen nennen, sollten sich überlegen, allein für Bing ein Linkedin-Profil anzulegen. Es liegt auf der Hand, dass das für Bing Chat eine wichtige Informationsquelle ist – denn Linkedin gehört wie Bing zum Microsoft-Konzern.

Die interessante Frage ist nun, ob es die veränderte Informationslage war, die es Bing Chat ermöglicht hat, eine bessere Antwort zu liefern – oder ob Microsoft auch an der Systematik gearbeitet hat, mit der solche personenbezogenen Auskünfte erteilt werden.

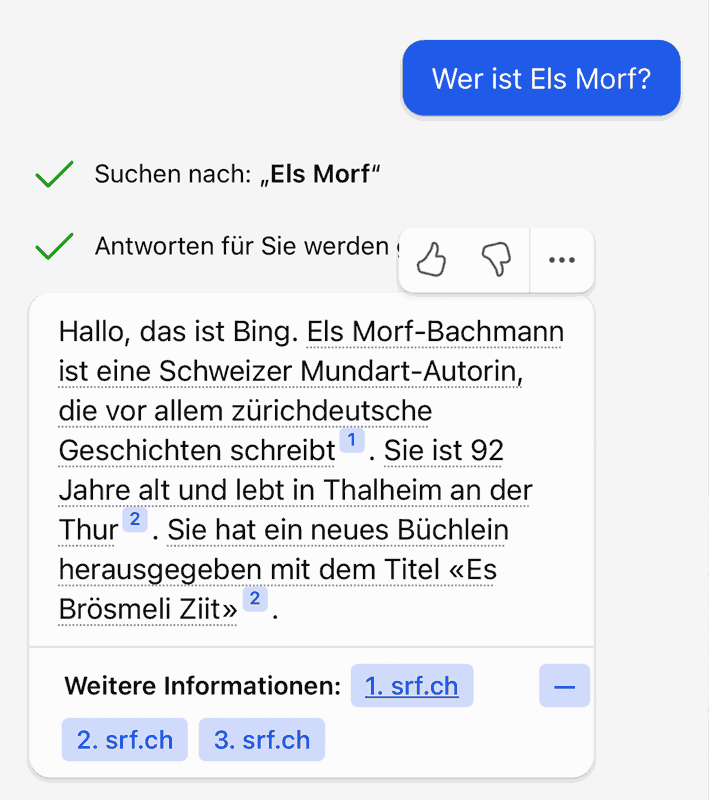

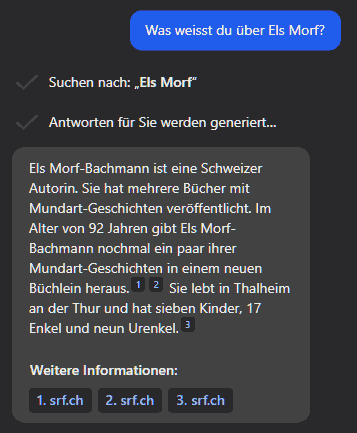

Das lässt sich anhand des zweiten Beispiels überprüfen, das ich vor drei Monaten ebenfalls schon einmal durchgeführt habe und das ebenso vernichtend ausgefallen ist. Ich habe damals Bing zu meiner Grossmutter befragt und festgestellt, dass Bing nicht in der Lage war, aus einem vor zehn Jahren veröffentlichten Online-Artikel das korrekte Alter abzuleiten.

Die Altersfalle ist ausgeräumt

Über meine Grossmutter sind seit dem letzten Test keine neuen Informationen im Netz aufgetaucht (wenn man von meinem Blogpost zu Bing absieht), sodass wesentliche Verbesserungen bei der Antwort auf Microsofts Arbeit an Bings Sprachmodell zurückzuführen wären. Und das ist bei diesem Test herausgekommen:

Es fällt auf, dass Bing nicht mehr in die Altersfalle tappt: Statt der Formulierung «Sie ist 92 Jahre alt» heisst es nun, dass sie «im Alter von 92 Jahren nochmals ein Buch herausgegeben» habe. Besser!

Der letzte Satz ist allerdings gleich doppelt falsch: Meine Grossmutter lebt nicht mehr in Thalheim, weil sie 2018 gestorben ist. Und während die Zahl der Kinder und Enkel gleichgeblieben ist, gibt es seitdem neue Urenkel zu vermelden.

Besser, aber nicht gut genug

Um zur Frage zu kommen, die ich im Titel stelle: Ist Bing mit diesen Verbesserungen bereit für die öffentliche Lancierung oder bahnt sich hier noch immer eine Katastrophe an?

Die Antwort hängt von der Art des Einsatzes ab: Nutzerinnen und Nutzer mit einem grundsätzlichen Verständnis für die Funktionsweise und die Grenzen solcher Sprachmodelle werden die Angaben von Bing sicherlich nicht unbesehen glauben, sondern kritisch hinterfragen. Ich selbst habe Bing in letzter Zeit einige Male so verwendet und Zeit gespart: Mit einer Frage wie «Wann hat Snapchat die selbstzerstörenden Nachrichten eingeführt?» komme ich via KI schneller zu einem Resultat, als wenn ich mir die Antwort auf herkömmlichem Weg ergoogeln müsste – und das gilt auch unter Berücksichtigung der Zeit, die ich für die Kontrolle der Bing-Antwort benötige.

Es ist aber eine unbestreitbare Tatsache, dass ein wesentlicher Teil der Nutzerschaft solche Werkzeuge nicht kritisch, sondern naiv benutzt, was nicht ohne negative Auswirkungen bleiben wird. Das sollten wir nicht einfach so hinnehmen. Darum hätte ich an Microsofts Stelle Bing Chat nicht schon jetzt für alle zugänglich lanciert. Ich halte das erst dann für vertretbar, wenn das Sprachmodell in der Lage ist, selbst eine gewisse Quellenkritik zu betreiben. Um beim Beispiel zu bleiben, müsste die Antwort einen Hinweis umfassen, dass die Auskunft auf einem zehn Jahre alten Artikel beruht, dessen Gültigkeit nicht mehr in allen Belangen gewährleistet ist.

Beitragsbild: A know-it-all robot that uses a computer to perform an Internet search (Adobe Firefly).

Das Problem bei statistischen Modellen wie ChatGPT ist, dass diese kein „weiss nicht“ kennen. Ihre Funktionsweise wird häufig missverstanden. Ich erkläre es Laien jeweils so: ChatGPT beantwortet nicht die gestellte Frage, sondern „Wie könnte eine Antwort auf die gestellte Frage aussehen?“. Ist man sich dessen bewusst, ist man nicht erstaunt, dass bei der Frage nach einem nicht existierenden Buch spätestens nach einer Nachfrage mit etwas (erfundenen) Details eine ausführliche Inhaltsbeschreibung kommt.

Wenn ChatGPT die Antwort weiss, antwortet es meist korrekt. Wenn es die Antwort nicht weiss, antwortet es so, wie eine Antwort aussehen würde, wenn es sie denn wüsste.

Genau: Sprachmodelle funktionieren nicht mit Wissen, sondern mit Statistik. Ich bin kein Statistiker (auch wenn ich das «Vergnügen» hatte, mich im Studium mit SPSS herumzuschlagen). Trotzdem frage ich mich, ob solche Modelle nicht auch eine Einschätzung zur Qualität der Datenlage hergeben würden. Ansonsten müssten statische Filter her – im Fall der Personensuche könnten die so aussehen, dass der Bot keine Auskunft gibt, wenn nicht mindestens ein Wikipedia-Beitrag oder eine Linkedin-Biografie vorhanden ist. Derlei Filter gibt es ja, zum Beispiel, wenn man nach offensichtlich illegalen Dingen fragt. Klar, sie lassen sich austricksen. Aber ist klar, dass jemand mit Vorsatz herangeht und nicht einfach durch Naivität bzw. mangelnde Medienkompetenz an fehlerhafte Informationen gerät.

Wie ich gerade gesehen habe, unterscheiden sich ChatGPT und der Bing-Chat wesentlich. ChatGPT verhält sich wie von mir beschrieben und liefert immer eine Antwort. Auf die Frage nach dem nicht existierenden Kinderbuch „Das kleine Äffchen auf grosser Reise“ antwortet es ausführlich mit Autor, Erscheinungsjahr und Inhaltsbeschreibung. Als Autor nennt es Hans Wilhelm. Dies ist tatsächlich ein Kinderbuchautor.

Der Bing-Chat antwortet auf die exakt identische Frage mit „ich weiss es nicht“. Auch mit „bitte suche noch einmal“ lässt er sich nicht zu einer falschen Antwort hinreissen.

Auf die Bitte nach Quellenangaben mit Links antwortet ChatGPT übrigens völlig selbstbewusst mit einem Link zur Website des Autors mit „/books/titel“ und einem Amazon-Link mit erfundener Artikelnummer. Eben so, wie eine Antwort aussehen könnte, wenn es das Buch gäbe.

Fazit: ChatGPT ist „nur“ Statistik, beim Bing-Chat ist noch eine Validierung eingebaut. Die prüft aber, wie Du erwähnt hast, nur, ob etwas im Internet steht und nicht, ob es auf einer seriösen Webseite steht.

Korrekte Antworten habe ich im Bing-Chat bis jetzt (12. Dez. 2023) nur für Rechenaufgaben erhalten. Die Frage nach einem Buchverleger hat eine Mischung von Behauptungen, die zu ca 40 % gefaked waren ergeben. Das Schlimmste aber war, dass diesem Verleger meine Telefon-Nr. zugeschrieben wurde. Bei der Frage nach meiner eigenen Person wurden mir diskriminierende, völlig erfundene Fakten unterstellt. Zum Beispiel wurde ich als Autor eines unsinnigen Textes genannt, der eine Seite füllend dargestellt wurde. Das ist nicht mehr nur mangelhaft, sondern bedenklich. Wiederholbar sind diese Auskünfte nicht. Bei wiederholter Fragestellung werden die Antworten variiert.