Internet ausdrucken und archivieren?

Link rot ist eine schöne englische Bezeichnung für ein hässliches Phänomen. In Deutsch spricht man von toten Links, wenn Verweise im Web ins Leere zielen. Das passiert immer wieder, weil Websites aus dem Netz verschwinden oder umgebaut werden. Es kommt auch vor, dass der Link zwar noch da ist, aber nicht mehr auf die ursprüngliche Information verweist – besonders ärgerlich, weil schwer zu erkennen.

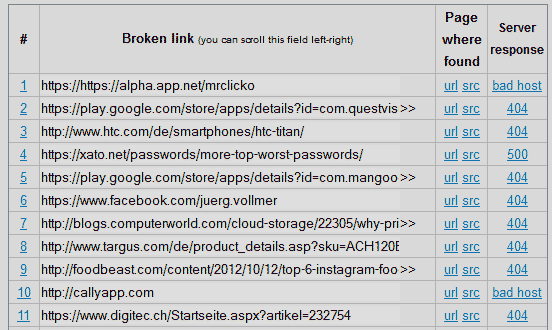

Der Online Broken Link Checker prüft kostenlos Websites auf tote Links. Er hat bei Clickomania.ch ungefähr auf jeder zwölften Seite einen veralteten Link gefunden – meistens 404-Fehler, die besagen, dass die angegebene Seite nicht mehr vorhanden ist. Mehrfach vertreten ist auch der Fehler 500, der auf ein Serverproblem schliessen lässt. Und der Fehler Bad host taucht bei den Sites auf, die aus dem Netz verschwunden sind, seit ich über sie geschrieben habe.

Hunderte toter Links

Das sind unter anderem cuil.com (Wie cool ist cuil?), promipranger.de (Websurditäten), gowalla.com (Wider den Checkin-Stress), swiss-webspace.ch (Top of Swiss web), museeka.com (Soziales Musikstreaming!) oder bookgenome.com (Websites für Bücherwürmer). Den Fehler Bad URL gibt es übrigens auch. Er erscheint dann, wenn ich beim Eintippen einer Adresse einen Fehler gemacht und etwas Ungültiges in den Link geschrieben habe.

Bei den toten Links im Blog kann man nicht viel machen. Die Beiträge nachträglich zu editieren, wäre mit unvertretbar viel Aufwand verbunden. Beiträge zu nicht mehr existenten Webdienste zu löschen, kommt auch nicht in Frage. Das würde ziemlich sicher wiederum tote Links an anderer Stelle erzeugen und widerspricht der Idee Internets oder eines Blogs IMHO grundsätzlich.

Lästig sind tote Links natürlich auch bei der Recherche. Wenn ich mich für einen Artikel auf wichtige Informationen aus dem Web beziehe, dann will ich in aller Regel sicherstellen, dass ich diese Information dokumentieren könnte, selbst wenn die ursprüngliche Site aus dem Web unvermittelt verschwinden würde. Da ich kein Internetausdrucker bin, speichere ich die Datei entweder als HTML bzw. als MAFF (siehe Gut versteckte Webbeute) oder ich drucke sie in eine PDF-Datei. Das ist übrigens auch eine gute Methode bei schlecht druckbaren Websites, eine einigermassen brauchbare Darstellung zu erhalten:

Nur das Wesentliche archivieren

Ich markiere unter Auslassung von Werbung, Navigation, Seitenleisten und anderem uninteressantem Klimbim nur den eigentlichen Textteil, betätige Drucken und aktiviere im Druckdialog die Option Markierung. So wird in die PDF-Datei nur der relevante Inhalt ausgegeben, Links, Formatierungen und Bilder bleiben aber erhalten.

Bei wichtigen Artikeln, die in Klickstrecken unterteilt sind, mache ich mir sogar die Mühe, jedes Portiönchen einzeln zu markieren, als PDF zu speichern und die PDFs in Acrobat in der richtigen Reihenfolge zu einer einzigen PDF-Datei zusammenzubauen. Das ist mit etwas Aufwand verbunden, ergibt aber ein sauberes Resultat, das nicht nur den Sachverhalt einwandfrei dokumentiert, sondern auch in Ruhe am Tablet gelesen und mittels Leuchtstift- oder Kommentar-Werkzeug behandelt werden kann. (Siehe dazu auch Lesen auf die gute Art und Offline-Dokumentationen mit dem iPad)

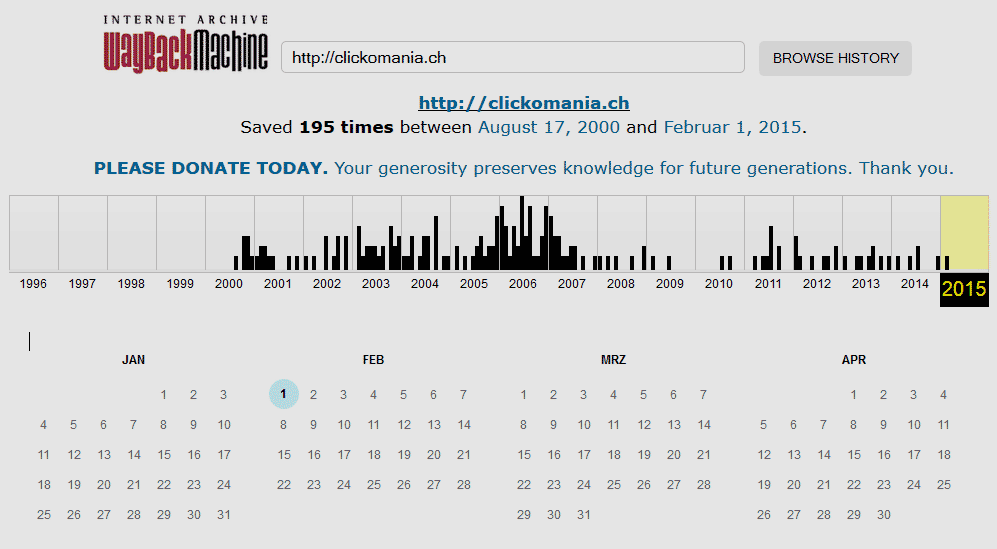

Das Speichern von Websites ist nicht ohne Tücke, wie ich im Kummerbox-Beitrag Die Kunst, Internetseiten zu archivieren ausgeführt habe. Wenn man eine Website nicht archiviert hat, aber dennoch an deren Inhalt herankommen will, dann probiert man es mit archive.org oder mit dem Google-Cache. Eine interessante Idee steckt auch hinter webcitation.org. Dieser Dienst dokumentiert Websites öffentlich.

Eine zitierbare Kopie im Web

Das geht wie folgt: Unter webcitation.org/archive.php erfasst man die URL zur Site, die man zitieren möchte, plus seine E-Mail-Adresse. Man kann optional auch einige Metadaten zum Autor, Schlagwörter und ein Veröffentlichungsdatum angeben. Danach wird die Seite zwischengespeichert, und den man dann gemäss Vorschlag von Webcitation wie folgt zitieren kann:

Matthias Schüssler. Hinlinken, ohne hinzulinken. clickomania.ch. 2015-03-26. URL: clickomania.ch/fp/index.php/2015/02/09/hinlinken-ohne-hinzulinken/. Accessed: 2015-03-26. (Archived by WebCite® at webcitation.org/6XJge7wRB)

Ausführliche Hinweise zum Thema finden sich in einem Beitrag von gwern.net, der archiviert auch bei archive.org zu finden ist. Hier findet man auch einige weitere Caching-Dienste, namentlich perma.cc, peeep.us oder archive.is.

Ich archiviere eigentlich alles, was irgendwie interessant ist, mit dem Evernote Clipper. Geht schnell, die Dokumente sind gut lesbar, Werbung ist meist entfernt und ich kann es später auch noch editieren und mit Notizen versehen. Ausserdem mit der Suche dann auch gut auffindbar, auch wenn man beim Taggen schludert. Ist auch mein Read me later Dienst.